維生素d 活化 定義 チェック

今日のポストでは、私は1枚だけでなく、5枚から素材を描きました!主題はword2vecで、Mikolovらの研究. 論文は次のとおりです。これらの論文の最初のもの(効率的な推定)から、単語ベクトルの学習のための連続語彙および連続スキップグラムモデルの説明が得られます(単語ベクトルが瞬間的に何かについて話します). 2番目の論文から、単語ベクトルの力、スキップグラムモデル(階層的なソフトマックスとネガティブサンプリング)の最適化に関するいくつかの追加情報、語句をフレーズに適用する議論. 3番目の論文(Linguistic Regularities)は、単語ベクトルに基づいたベクトル指向の推論を記述し、有名なKing Man Woman = Queenの例を紹介しています. 最後の2つの論文は、Milokovの論文の中で非常に簡潔に表現されたアイデアのいくつかの詳細な説明を提供しています. 単純な1-of-N(またはone-hot)エンコーディングでは、ベクトルのすべての要素がボキャブラリ内の単語に関連付けられます. 与えられた単語のエンコーディングは、単に対応する要素が1に設定され、他のすべての要素が0であるベクトルです.

私たちの語彙には、キング、クイーン、マン、ウーマン、チャイルドの5つの単語しかないとします. クイーンという言葉を次のようにエンコードすることができます:

このようなエンコーディングを使用することで、等価性テスト以外の単語ベクトル間で意味のある比較はできません. そのため、ベクトルの要素と単語の間に1対1のマッピングの代わりに、単語の表現はベクトルのすべての要素に広がり、ベクトルの各要素は多くの単語の定義に寄与します.

仮説的な単語ベクトルの次元にラベルを付けると(当然のアルゴリズムでそのような事前に割り当てられたラベルはありません)、これはちょっと見えるかもしれません:

このようなベクトルは、ある抽象的な方法で、単語の意味を表すようになる. 次に、大きなコーパスを調べるだけで、単語間の関係を驚くほど表現力豊かな方法で捉えることができる単語ベクトルを学習することができます.

単語ベクトルの推論

実際には、学習された単語表現は、意味のある構文的および意味的規則性を非常に簡単な方法で取り込む. 具体的には、規則性は、特定の関係を共有する単語の対の間の一定のベクトルオフセットとして観察される. 例えば、単語iのベクトルをxiとし、特異/複数の関係に注目すると、xapple xapples xcar xcars、xfamily xfamilies xcar xcarsなどが観測されます.

維生素d 活化 定義 チェック つづり

おそらくもっと驚くべきことに、これは、SemEval 2012の関係類似性測定タスクによって測定されるような、さまざまな意味関係にも当てはまることがわかります. 例えば、叔父がいるように男は女性になるのですか?コサイン距離に基づく単純なベクトルオフセット法を使用して(叔母).

たとえば、ジェンダー関係を示す3つの単語ペアのベクトルオフセットは次のとおりです。

ここでは、単数形の複数の関係を見ていきます。

この種のベクトル構成は、King Man Woman =にも答えることができます。質問と結果女王に到着!これらの知識のすべてが、意味論について提供された他の情報なしで文脈の中でたくさんの言葉を見ているだけであると思うとき、本当に顕著です. 単純な代数演算が単語ベクトルに対して実行される単語オフセット技法を用いて、ベクトル(King)ベクトル(Man) ベクトル(Woman)がワードQueenのベクトル表現に最も近いベクトルとなることが示された.

キング、マン、クイーン、&女性のためのベクトル:

ベクトルの構成King Man Woman =の結果は?

同じテクニックを使って達成されたいくつかの結果がここにあります:

ここでは、2次元のPCA予測において、国と首都の関係がどのように見えるかを示します。

ここでは、cのようにaのbのいくつかの例がありますか?単語のベクトルによって答えられるスタイルの質問:

ドイツ語 航空会社のような質問をするために、要素ごとにベクトル要素を追加することもできます。複合ベクトルに最も近いトークンを見ることで、印象的な答えが得られます。

そのような意味関係を持つ単語ベクトルは、機械翻訳、情報検索、質問応答システムなどの多くの既存のNLPアプリケーションを改善するために使用することができ、未来の他のアプリケーションをまだ開発できない可能性があります.

セマンティック・シンタックス・ワード関係は、以下に示すような多種多様な関係を理解するためのテストです. 640次元のワードベクトルを用いて、スキップグラム訓練モデルは55%の意味精度と59%の構文精度を達成した. 単語の連続的なベクトル表現を最初に使用したことはありませんでしたが、大量のデータを使って高次元の単語ベクトルを学習することが現実的となるように、そのような表現を学習する計算の複雑さをいかに減らすかを示しました. たとえば、Googleでは単語ベクトルのトレーニングにGoogleニュースコーパスを使用しています. 語彙のサイズを100万の最も頻繁な単語に制限しました

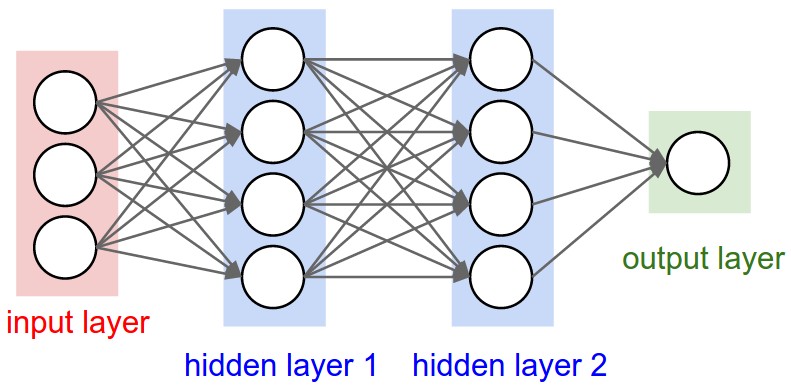

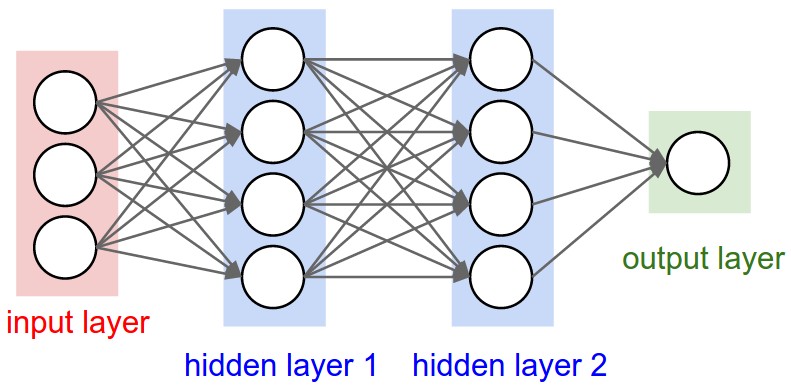

ニューラルネットワーク言語モデル(フィードフォワードまたはリカレント)の複雑さは、非線形隠れ層からもたらされ、.

これがニューラルネットワークを非常に魅力的なものにする一方で、我々はニューラルネットワークと同じくらい正確にデータを表現できないかもしれないより簡単なモデルを探索することに決めましたが、より多くのデータを効率的に訓練することができます.

2つの新しいアーキテクチャが提案されている:Continuous Bag-of-WordsモデルとContinuous Skip-gramモデル.

最近導入された連続Skip-gramモデルは、高品質の分散ベクトル表現を学習するための効率的な方法であり、多数のprecitesを取り込む構文的および意味的な単語の関係. テキストの上に、4つの単語とそれに先行する現在の中心単語とそれに続く4つの単語を含むスライディングウィンドウを想像してみましょう:

文脈語は入力層を形成する. 各単語はワンホット形式でコード化されているので、ボキャブラリのサイズがVの場合、要素の1つが1に設定されたV次元のベクトルになり、残りはすべてゼロになります.

訓練の目的は、入力文脈語が与えられたときの実際の出力単語(フォーカス単語)を観察する条件付き確率を最大にすることであり、重み.

維生素d 活化 定義 チェック ツール

我々の例では、入力(効率的、方法、for、高、品質、分散、ベクトル)が与えられれば、出力として学習を得る確率を最大化したい.

我々の入力ベクトルは1ホットであるので、入力ベクトルに重み行列W1を乗算することは、単にW1から行を選択することになる.

C個の入力ワードベクトルが与えられると、隠れ層hの活性化関数は、W1の対応するホット行を単純に合計し、その平均をとるためにCで割ることになる.

隠れ層から出力層まで、第2重み行列W2を用いて、語彙の各単語のスコアを計算することができ、softmaxを使用して単語の事後分布を得ることができる. これは、単一の入力ベクトルとしてフォーカス単語で構成され、ターゲットコンテキストワードは出力レイヤーにあります。

隠れ層の活性化関数は、以前に見たように重み行列W1(線形)から対応する行を単にコピーすることになる. 訓練の目的は、出力レイヤ内のすべてのコンテキストワードにわたる合計予測誤差を最小限にすることです. この例では、入力が学習されており、出力レイヤで(効率的なメソッド、高品質の、品質の高い、分散されたベクトル)を見たいと考えています.

最適化

トレーニングインスタンス内のすべての単語のすべての出力単語ベクトルを更新することは非常に高価です .

この問題を解決するには、トレーニングインスタンスごとに更新する必要がある出力ベクトルの数を制限することが直感です. これを達成するための優雅なアプローチは、階層的なsoftmaxです。別のアプローチはサンプリングによるものです.

階層的ソフトマックスは、バイナリツリーを使用して語彙のすべての単語を表現する. 各リーフに対して、ルートからリーフまでの一意のパスが存在し、このパスは、リーフによって表される単語の確率を推定するために使用される. この確率を、問題の葉で根の終わりから始まるランダムな歩行の確率として定義する.

維生素d 活化 定義 チェック やり方

主な利点は、確率分布を得るためにニューラルネットワークのV出力ノードを評価するのではなく、log2(V)単語だけを評価することです。バイナリハフマンツリーを使用します。速い訓練をもたらす頻繁な言葉.

ネガティブサンプリングは単に、反復ごとに出力語のサンプルを更新するという考え方にすぎません. ターゲットの出力単語はサンプルに保存され、更新され、負のサンプルとしていくつかの(ターゲットではない)単語が追加されます.

サンプリングプロセスには確率的分布が必要であり、任意に選ぶことができる。実験的に良好な分布を決定することができる. トレーニングセットの中のまれな単語と頻繁な単語との間の不均衡に対処するための簡単なサブサンプリング手法を使用することもできます(たとえば、、、およびはまれな単語よりも少ない情報価値を提供します). トレーニングセットの各単語は確率P(wi)で破棄されます。ここで、

f(wi)は単語wiの頻度であり、tは選択された閾値であり、典型的には約10-5.

今日のポストでは、私は1枚だけでなく、5枚から素材を描きました!主題はword2vecで、Mikolovらの研究. 論文は次のとおりです。これらの論文の最初のもの(効率的な推定)から、単語ベクトルの学習のための連続語彙および連続スキップグラムモデルの説明が得られます(単語ベクトルが瞬間的に何かについて話します). 2番目の論文から、単語ベクトルの力、スキップグラムモデル(階層的なソフトマックスとネガティブサンプリング)の最適化に関するいくつかの追加情報、語句をフレーズに適用する議論. 3番目の論文(Linguistic Regularities)は、単語ベクトルに基づいたベクトル指向の推論を記述し、有名なKing Man Woman = Queenの例を紹介しています. 最後の2つの論文は、Milokovの論文の中で非常に簡潔に表現されたアイデアのいくつかの詳細な説明を提供しています. 単純な1-of-N(またはone-hot)エンコーディングでは、ベクトルのすべての要素がボキャブラリ内の単語に関連付けられます. 与えられた単語のエンコーディングは、単に対応する要素が1に設定され、他のすべての要素が0であるベクトルです.

私たちの語彙には、キング、クイーン、マン、ウーマン、チャイルドの5つの単語しかないとします. クイーンという言葉を次のようにエンコードすることができます:

このようなエンコーディングを使用することで、等価性テスト以外の単語ベクトル間で意味のある比較はできません. そのため、ベクトルの要素と単語の間に1対1のマッピングの代わりに、単語の表現はベクトルのすべての要素に広がり、ベクトルの各要素は多くの単語の定義に寄与します.

仮説的な単語ベクトルの次元にラベルを付けると(当然のアルゴリズムでそのような事前に割り当てられたラベルはありません)、これはちょっと見えるかもしれません:

このようなベクトルは、ある抽象的な方法で、単語の意味を表すようになる. 次に、大きなコーパスを調べるだけで、単語間の関係を驚くほど表現力豊かな方法で捉えることができる単語ベクトルを学習することができます.

単語ベクトルの推論

実際には、学習された単語表現は、意味のある構文的および意味的規則性を非常に簡単な方法で取り込む. 具体的には、規則性は、特定の関係を共有する単語の対の間の一定のベクトルオフセットとして観察される. 例えば、単語iのベクトルをxiとし、特異/複数の関係に注目すると、xapple xapples xcar xcars、xfamily xfamilies xcar xcarsなどが観測されます.

今日のポストでは、私は1枚だけでなく、5枚から素材を描きました!主題はword2vecで、Mikolovらの研究. 論文は次のとおりです。これらの論文の最初のもの(効率的な推定)から、単語ベクトルの学習のための連続語彙および連続スキップグラムモデルの説明が得られます(単語ベクトルが瞬間的に何かについて話します). 2番目の論文から、単語ベクトルの力、スキップグラムモデル(階層的なソフトマックスとネガティブサンプリング)の最適化に関するいくつかの追加情報、語句をフレーズに適用する議論. 3番目の論文(Linguistic Regularities)は、単語ベクトルに基づいたベクトル指向の推論を記述し、有名なKing Man Woman = Queenの例を紹介しています. 最後の2つの論文は、Milokovの論文の中で非常に簡潔に表現されたアイデアのいくつかの詳細な説明を提供しています. 単純な1-of-N(またはone-hot)エンコーディングでは、ベクトルのすべての要素がボキャブラリ内の単語に関連付けられます. 与えられた単語のエンコーディングは、単に対応する要素が1に設定され、他のすべての要素が0であるベクトルです.

私たちの語彙には、キング、クイーン、マン、ウーマン、チャイルドの5つの単語しかないとします. クイーンという言葉を次のようにエンコードすることができます:

このようなエンコーディングを使用することで、等価性テスト以外の単語ベクトル間で意味のある比較はできません. そのため、ベクトルの要素と単語の間に1対1のマッピングの代わりに、単語の表現はベクトルのすべての要素に広がり、ベクトルの各要素は多くの単語の定義に寄与します.

仮説的な単語ベクトルの次元にラベルを付けると(当然のアルゴリズムでそのような事前に割り当てられたラベルはありません)、これはちょっと見えるかもしれません:

このようなベクトルは、ある抽象的な方法で、単語の意味を表すようになる. 次に、大きなコーパスを調べるだけで、単語間の関係を驚くほど表現力豊かな方法で捉えることができる単語ベクトルを学習することができます.

単語ベクトルの推論

実際には、学習された単語表現は、意味のある構文的および意味的規則性を非常に簡単な方法で取り込む. 具体的には、規則性は、特定の関係を共有する単語の対の間の一定のベクトルオフセットとして観察される. 例えば、単語iのベクトルをxiとし、特異/複数の関係に注目すると、xapple xapples xcar xcars、xfamily xfamilies xcar xcarsなどが観測されます.